神经网络中激活函数的作用

为什么要有激活函数

激活函数是在神经网络中必须要用到的。神经网络中的输入经过线性运算向后传递,即输入乘权重加偏移然后经过非线性的激活函数的映射后得到最终的输出。通过反向传播更新权重从而不断拟合输入与输出的关系。

我们知道,现实生活中复杂系统的输入与输出之间的关系绝大部分都是非线性的,所以神经网络学习到的输入与输出的映射关系也应当是非线性的。因此必须要有激活函数对输入输出进行非线性的映射,来更好的拟合二者间的关系。

如果没有激活函数,或者激活函数是线性形式的话,不论神经网络有多少层隐含层,这些线性函数的复合最终依然是线性形式,中间层的权重与偏差最后都可以进行合并,就失去了隐含层的作用。

常见激活函数

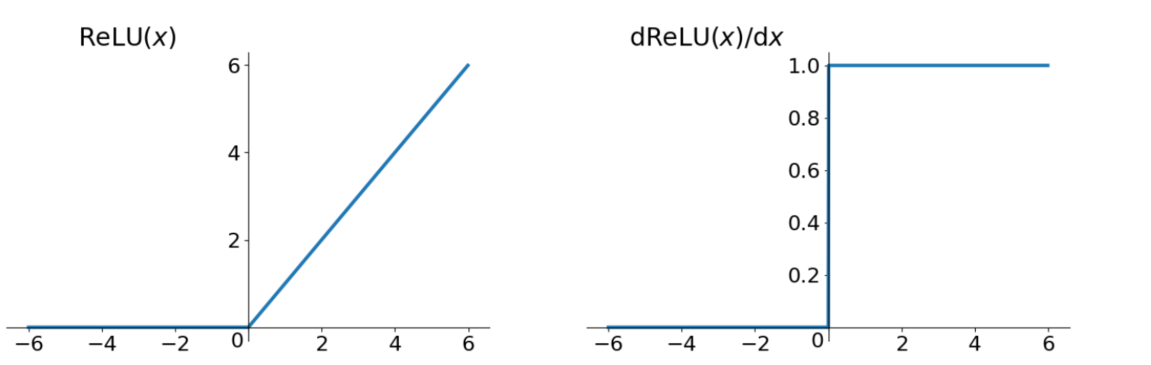

ReLU(修正线性单元)

tanh(双曲正切函数)

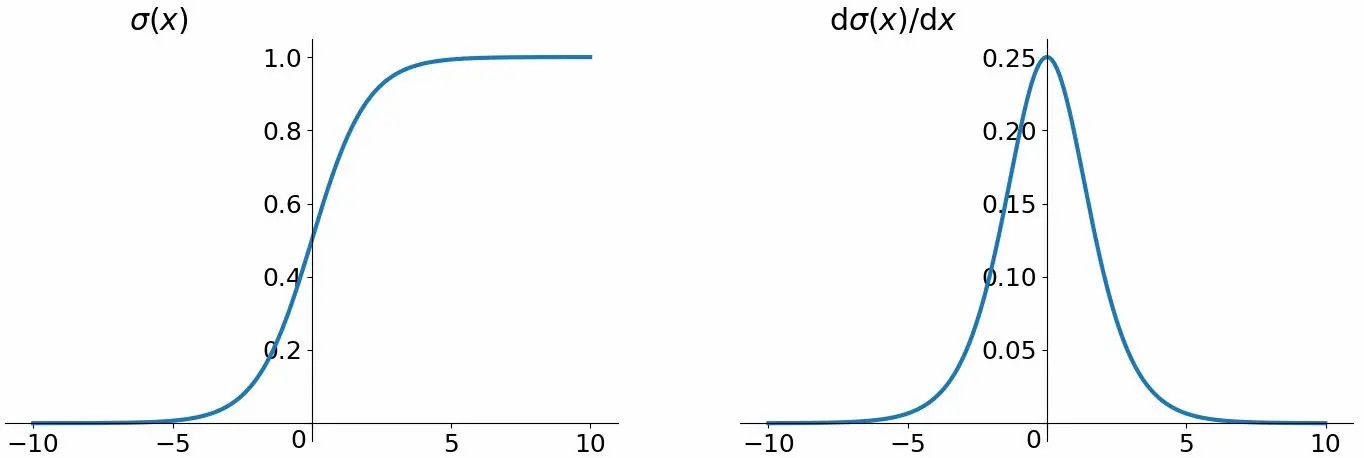

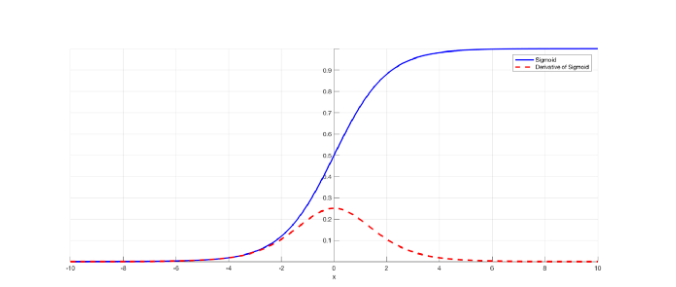

Sigmoid(Logistic)

本文是原创文章,采用CC BY-NC-SA 4.0协议,完整转载请注明来自DaneSun's Blog

评论

匿名评论

✅ 你无需删除空行,直接评论以获取最佳展示效果